Los buzzwords de IA en 2025: le ayudamos a descifrarlos

Director Sénior en el área de transformación de Datos e IA de Converteo, Charles Letaillieur acompaña a las organizaciones en sus ambiciones estratégicas relacionadas con la inteligencia artificial. Experto reconocido en IA generativa e IA agentiva, diseña e implementa soluciones innovadoras pero pragmáticas, perfectamente adaptadas a los contextos específicos de cada empresa. Su enfoque permite materializar el potencial transformador de las tecnologías de IA avanzadas, anclándolas en una visión de negocio clara y en casos de uso con alto valor añadido.

A principios del segundo trimestre de 2025, acudimos en su ayuda para descifrar los últimos términos de moda en IA. En 2025, el panorama tecnológico continúa enriqueciéndose con multitud de nuevos conceptos. Tanto si es usted un profesional experimentado como si simplemente siente curiosidad por las evoluciones digitales, comprender estos términos resulta esencial para navegar en nuestro entorno digital.

Esta lista desmitifica estos conceptos clave, ofreciéndole una comprensión precisa de su significado y potencial de aplicación. Más allá de la jerga, estas innovaciones representan verdaderas oportunidades para transformar su enfoque de los datos y de la IA.

IA agentica

La IA agentiva representa una forma avanzada de inteligencia artificial generativa caracterizada por su capacidad para funcionar de manera autónoma, tomando decisiones y realizando tareas complejas adaptándose dinámicamente a su entorno.

Esta tecnología marca una evolución significativa hacia sistemas que operan con una autonomía creciente, sin necesitar una supervisión humana constante. Esta transformación se basa en evoluciones recientes de los modelos. Los modelos como GPT-4o (actualmente 4.5) o Gemini 2.0 (actualmente 2.5) son multimodales, es decir, analizan y pueden generar texto, imagen, audio y vídeo, y además poseen capacidades de cálculo y lógica más avanzadas. Estas capacidades de razonamiento avanzado les permiten una toma de decisiones autónoma.

Esta multimodalidad, junto con las interconexiones a la mayoría de las pilas de SI (CRM, CDP, ERP, herramienta de ticketing, etc.), hace que estos agentes sean capaces de orquestar flujos de trabajo complejos, adaptándose en tiempo real a los cambios y coordinando diversos sistemas.

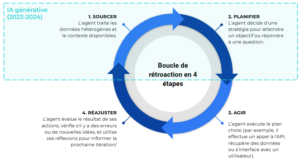

Finalmente, la novedad reside en un marco de mejora continua que sistematiza un bucle de 4 etapas:

- Recopilar datos

- Planificar (o sugerir)

- Actuar

- Reajustar

La IA generativa, tal como la hemos visto implementarse en los últimos 2 años, generalmente se detiene en las dos primeras etapas (recopilar datos, planificar). Por ejemplo, la generación de contenido a gran escala recopila los datos útiles (datos de productos, tono de voz, etc.) y sugiere contenidos optimizados. La IA agentiva publica automáticamente sus contenidos en el sitio web y reajusta el proceso monitorizando continuamente los impactos SEO/SEA y adaptando el agente de creación de contenido para que produzca contenidos más pertinentes.

El ecosistema de herramientas de IA agentiva se desarrolla muy rápidamente con plataformas como AgentSpace de Google, que facilita la creación y el despliegue de agentes personalizados; AgentForce de Salesforce, que optimiza la coordinación entre múltiples agentes; y Dust, que permite construir flujos de trabajo de agentes especializados.

Actores puramente digitales (pure players) más pequeños, pero también más ágiles, como Dust, Relevance, CrewAI, Kleio.ai.

La IA agentiva ofrece ventajas considerables en términos de eficiencia operativa y reducción de costes gracias a la automatización inteligente de procesos complejos. También plantea muchas cuestiones sobre todos los procesos de la empresa que deben ser rediseñados (personal, herramientas, interacciones, etapas, etc.).

RAG (Retrieval-Augmented Generation)

El RAG (Generación Aumentada por Recuperación) mejora significativamente los grandes modelos de lenguaje al combinar su capacidad generativa con el acceso a información precisa y actualizada. Pionera contra las alucinaciones de las IA, esta técnica se encuentra ahora en el núcleo de soluciones avanzadas como AgentSpace o Dust.

Su funcionamiento se articula en tres fases: extracción de información pertinente de diversas fuentes externas, transformación en vectores (representaciones numéricas que capturan el significado de los datos en un formato que la IA puede procesar eficazmente) y, finalmente, enriquecimiento del contexto del modelo para generar respuestas precisas y documentadas.

La ventaja clave del RAG es su capacidad para proporcionar respuestas basadas en información actualizada y específica, superando las limitaciones de los conocimientos estáticos de los LLM tradicionales. Este enfoque permite adaptar rápidamente los sistemas a diferentes dominios sin un reentrenamiento costoso.

Las aplicaciones incluyen sistemas de pregunta-respuesta que proporcionan información verificable y herramientas de generación de contenido basadas en fuentes fiables.

El RAG establece así un puente entre la fluidez lingüística y la precisión fáctica, permitiendo la creación de asistentes artificiales más fiables y mejor informados.

LLM as a Judge

«LLM como juez» (LLM as a Judge) designa el uso de modelos de lenguaje de gran tamaño (LLM) para automatizar la evaluación de los textos generados por sistemas de inteligencia artificial, ya sean otros LLM o soluciones de IA. Estos modelos son capaces de analizar diversos criterios como la precisión, la coherencia, la fluidez y la pertinencia, permitiendo así reemplazar o complementar las evaluaciones humanas. El uso de estos modelos por su capacidad crítica surgió con el auge de los LLM, que demostraron una aptitud sorprendente para comprender, analizar y juzgar producciones textuales con un alto grado de precisión. Desde entonces, los investigadores y las empresas han visto un potencial considerable en la explotación de esta capacidad para automatizar la evaluación de contenido y mejorar la interacción con los sistemas de IA.

Este enfoque se utiliza actualmente en ámbitos como la moderación de contenido en línea, la mejora de los chatbots, la evaluación de las traducciones automáticas y la optimización de las respuestas generadas por IA. Empresas como Giskard, así como plataformas como Google Vertex AI a través de su módulo Evaluation, ofrecen herramientas que permiten implementar estos modelos en diversos contextos.

En resumen, «LLM como juez» abre la vía a evaluaciones automatisadas de alta calidad, fomentando un análisis escalable y eficaz de los textos generados por IA, al tiempo que ofrece una alternativa a los métodos de evaluación tradicionales.

MLOps

El MLOps representa un enfoque estructurado que transforma las pruebas de concepto (PoC) en soluciones de IA operativas. Al fusionar las prácticas de DevOps con las especificidades del aprendizaje automático (machine learning), esta metodología responde a los desafíos únicos del despliegue de modelos en producción, integrando actualmente una dimensión FinOps para controlar los costes crecientes.

Su esencia reside en la automatización de los procesos críticos (desarrollo, prueba, despliegue y mantenimiento), convirtiendo experimentaciones en soluciones robustas. El MLOps establece un puente esencial entre los científicos de datos (data scientists) y los equipos de TI, fomentando una colaboración que maximiza el valor de los modelos.

Un pilar fundamental es la monitorización continua del rendimiento en producción. Esta vigilancia asegura la pertinencia de los modelos frente a las evoluciones de los datos y del contexto empresarial, previniendo la degradación silenciosa que amenaza la eficacia de los sistemas de IA.

Al estandarizar estos procesos, el MLOps acelera considerablemente la puesta en producción, reduciendo los plazos de comercialización. Esta agilidad permite a las organizaciones capitalizar rápidamente las oportunidades y adaptar sus modelos a las exigencias evolutivas del mercado.

Esta disciplina se impone como imprescindible para transformar de forma duradera las iniciativas de ML en ventajas competitivas medibles.

Responsible AI

La IA responsable es un enfoque que integra consideraciones éticas y de soberanía para garantizar la seguridad y la fiabilidad. Se basa en principios de transparencia, equidad, respeto de la privacidad y responsabilidad. Al establecer marcos de gobernanza e implicar a expertos en ética, derecho y ciencias sociales, la IA responsable tiene como objetivo maximizar los beneficios para la sociedad minimizando al mismo tiempo los riesgos, como la discriminación y la violación de la privacidad. Esto permite reforzar la confianza del público y asegurar una alineación con los valores sociales y las normas regulatorias emergentes.

En este contexto de evolución constante, Converteo pone a su disposición su experiencia para acompañarle en la exploración y adopción de estas nuevas tecnologías. Nuestro enfoque personalizado le permite navegar con serenidad por este complejo panorama, identificando las soluciones más pertinentes para sus desafíos específicos.

Le ayudamos a transformar estos conceptos innovadores en ventajas concretas para su organización, asegurando al mismo tiempo una implementación que respete sus valores y responda precisamente a sus necesidades. Nuestro objetivo es permitirle explotar plenamente el potencial de estas tecnologías emergentes, integrándolas armoniosamente en su estrategia global.