Bonnes pratiques SEO : Retour sur le SMX Advanced Seattle par Activis

Grand-messe du Search Marketing réservée à une brochette d’experts triés sur le volet, le SMX Advanced du mois de juin était l’occasion pour les acteurs influents du digital de partager leurs dernières recommandations en matière de Search.

Seul acteur français convié, l’agence Activis organisait le 18 septembre une conférence pour présenter une synthèse des points les plus marquants du SMX Advanced. Voici un rapide retour sur les principaux sujets évoqués par Activis.

1. Le Mobile :

Le poids du mobile dans les requêtes SEO est en croissance rapide : 22% des requêtes SEO sont aujourd’hui effectuées sur mobile et la barre des 50% devrait être atteinte dès 2015. On prend ici la mesure de l’importance du sujet mobile dans une logique d’optimisation du référencement naturel. Le premier facteur à considérer est celui de la technologie utilisée pour les sites mobiles. Sites mobiles dédiés (ex : m.nomdedomaine.com), sites en responsive design ou sites en « dynamic serving » (une URL unique mais un code HTML différent chargé selon le device) ne se valent pas tous d’un point de vue SEO. Les sites mobiles dédiés seront par exemple pénalisés par l’absence de backlinks au lancement, tandis que les sites responsive font en général face à des problèmes de temps de chargement plus élevés généralement liés à des problèmes de tailles d’images. Si l’on n’observe pas de réelle corrélation entre la technologie mobile utilisée et le positionnement SEO, on sait que Google recommande fortement l’utilisation de sites responsive design. Le temps de chargement étant un facteur important pour l’expérience utilisateur et le SEO (de plus en plus pris en compte), la meilleure pratique semble donc de développer un site responsive en portant une attention particulière à l’optimisation du poids des images et des ressources (JS, CSS, …). Pour vous aider à améliorer le temps de chargement de vos pages sur mobile, Google a mis à disposition l’excellent outil Page Speed Insights. Celui-ci évalue la vitesse de chargement de vos pages (sur desktop et mobile) et vous indique les principaux points d’optimisation identifiés.

2. Le Contenu :

« Content is king », l’adage est toujours d’actualité mais la production de contenu reste complexe et coûteuse ! Une bonne pratique consiste donc à donner une 2° vie aux anciens contenus en les recyclant sur de nouveaux supports. On peut par exemple :

- Utiliser un article de blog pour en extraire quelques chiffres clés et composer une infographie. On peut ensuite découper l’infographie en images pour les présenter sur un Slideshare ou en intégrer certaines comme illustrations pour d’autres articles.

- Prendre une vidéo diffusée sur Youtube et la pousser sur Facebook pour bénéficier de l’autoload des vidéos, puis en extraire une séquence courte diffusée sous forme de Vine.

Le recyclage de contenus à travers de multiples supports est également une bonne pratique car il permet de toucher des audiences différentes dont certaines peuvent s’avérer plus virales que d’autres.

3. La Sécurité :

Depuis quelques temps déjà Google a passé ses pages de résultats de recherche en HTTPS et masque dans Google Analytics les mots-clés tapés par les internautes connectés à leurs comptes Google. Cette démarche s’inscrit dans une volonté globale de Google de pousser tous les sites à se sécuriser davantage. On comprend donc que les sites full HTTPS seront prochainement favorisés par Google en SEO. Pour déployer un site sécurisé les prérequis sont :

- Utiliser un serveur compatible HTTPS

- Acheter un certificat de sécurité (SSL ou TLS qui serait préféré par Google)

- Ne pas oublier de sécuriser également toutes les ressources (images, scripts, CSS, …)

Lorsqu’on dispose déjà d’un site web non sécurisé, il faut passer des redirections 301 sur toutes les URL du site HTTP vers la version HTTPS (attention tout de même à éviter les superpositions de redirections peu appréciées par Google).

4. L’Indexation :

Google a confirmé que l’Ajax et le JS sont bien indexés, les liens JS ayant d’ailleurs le même poids que les liens HTML. Google recommande par ailleurs de ne pas bloquer les ressources du site (scripts, CSS, …) via le fichier robots.txt qui est utilisé par les moteurs de recherche pour savoir quelles pages doivent être indexées ou pas. Un outil de test de crawl devrait prochainement être intégré à Google Webmaster Tools pour faciliter la compréhension de la façon dont Google interprète le contenu d’une page ce qui devrait s’avérer très utile !

5. Les Données structurées schema.org :

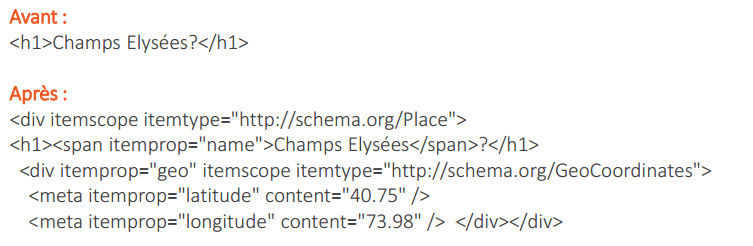

Il s’agit d’une forme de balisage du code HTML qui permet aux moteurs de recherche de donner du sens et d’enrichir le contenu des pages d’un site. A travers ce balisage on rattache une page à une catégorie et puis on lui attribue un certain nombre de données de façon structurée. Une page comprenant le mot « Champs Elysées » peut par exemple traiter d’un lieu (l’avenue parisienne), d’une chanson (de Joe Dassin) ou encore de la mythologie. Le recours au balisage schema.org permet par exemple de déclarer qu’au sens de notre page il s’agit d’un lieu, puis de lui attribuer des propriétés (ici : latitude et longitude).  Le balisage schema.org est reconnu à la fois par Google, Yahoo et Bing qui y ont travaillé ensemble. Il présente un double avantage :

Le balisage schema.org est reconnu à la fois par Google, Yahoo et Bing qui y ont travaillé ensemble. Il présente un double avantage :

- Les moteurs favorisent le ranking des pages dont ils comprennent bien le sens.

- Certaines données structurées, comme les évaluations produit sous forme d’étoiles, peuvent s’afficher directement dans les pages de résultats de recherche et ainsi favoriser le taux de clic du lien (leur affichage n’est pas systématique et dépend de la notoriété du site ainsi que du nombre de pages traitées).

6. Les Ranking factors :

Nous vous proposons ici un petit décryptage des grandes tendances concernant les facteurs pris en compte par Google dans la détermination du positionnement d’un site en SEO :

-

- Le temps de chargement : c’est un peu le nouveau PageRank pour Google qui y accorde une importance croissante. L’optimisation du temps de chargement et plus généralement du fonctionnement technique et de la « propreté » du code doit devenir une préoccupation majeure pour le SEO.

-

- Le contenu : le contenu semble prendre encore plus de poids pour Google. Concernant les articles, on recommande aujourd’hui de rédiger des articles de 650 à 750 mots. Le « stuffing » de mots-clés est de plus en plus sanctionné par Google et on recommande de ne pas dépasser une densité de 3% pour le mot-clé principal. Enfin Google valorise particulièrement les articles présentant une approche holistique d’un sujet à savoir un article qui couvre un sujet de façon très large, incluant des perspectives communément abordées mais aussi des éléments beaucoup moins couverts sur le web se traduisant par des associations de mots-clés rares et précises.

-

- Le profil de liens : le netlinking reste l’un des facteurs les plus importants en SEO. L’objectif est d’avoir de nombreux liens entrant vers votre site en privilégiant les liens de qualité (en provenance de sites à forte notoriété et dans un contexte adapté). Le « profil de liens » ainsi constitué doit sembler le plus naturel possible à Google, de sorte que le site ne soit pas soupçonné de sur-optimisation. Ainsi les sources des liens doivent être variées (articles de blog, forum, commentaires de blog, social media, agrégateurs de contenus, …), de même que les supports (lien texte ou image), les mots-clés utilisés en texte d’ancrage et les landing pages. Par ailleurs il est important de compter une certaine proportion de liens « nofollow » dans cette logique de profil « naturel » même s’ils paraissent peu profitables.

-

- Les partages sociaux : L’impact des partages sur les réseaux sociaux est globalement en perte de vitesse. Le « +1 » de Google reste le plus impactant.

Conclusion :

Dans une logique SEO, la roadmap 2015 devra se concentrer sur les sujets suivants : 1) Mobile 2) Content 3) Performance technique