Scraping : Comment améliorer sa prise de décision grâce au datascraping et à la données des concurrents ?

Pour piloter au mieux son offre, disposer d’une vision quantitative des pratiques de ses concurrents directs constitue souvent un avantage majeur. Internet regorge de données pertinentes à analyser pour cerner au mieux son positionnement produit/prix. Les prix pratiqués, la profondeur des gammes exposées, les stratégies promotionnelles : ce sont autant d’indicateurs clés.

Le scraping de la donnée ou datascraping, qu’est-ce que c’est ?

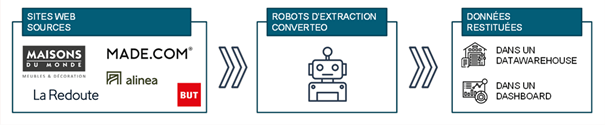

Récupérer des données laissées libres d’accès pour dresser un panorama pragmatique et complet d’un marché, c’est précisément le but d’une activité de scraping. Le scraping consiste à opérer une compilation à usage privé de données publiques en réalisant l’extraction de ces données publiques d’un site web via des algorithmes dédiés à cette tâche. Concrètement, ce sont donc des robots qui industrialisent à grande échelle l’action de copier/coller dans des bases de données privées du contenu public.

Scraping de la donnée concurrente : exemple d’une marque de meubles

Le scraping de la donnée, pour quoi faire ?

Le scraping de la donnée publique de la concurrence permet de digitaliser sa veille concurrentielle et d’affiner son positionnement produit/prix. Les informations pertinentes collectées en masse seront utilisées différemment, en fonction des enjeux business des acteurs, mais pour des e-commerçants, il s’agit généralement des informations liées aux produits (prix, notations clients, largeur et profondeur de catalogue, ordre d’apparition des produits dans les résultats de recherche entre autres).

Une fois retraitées, ces données permettent de prendre des actions opérationnelles concrètes : réalignement des prix, lancement d’une nouvelle gamme d’offres pour combler un manque, renégociations commerciales ou nouvelles négociations commerciales avec des partenaires dans le cadre d’un marketplace.

Les informations récupérées, qui peuvent être soit exploitées brutes dans le cadre d’analyses soit mises en lumières dans des dashboards opérationnels viennent renforcer les convictions d’une marque, en permettant de mieux cerner les évolutions et tendances d’un écosystème.

Le scraping de la donnée, quelles limites ?

Les limitations légales du scraping

La légalité du scraping fait parfois débat. Les données compilées étant publiques, les récolter ne représente pas une atteinte manifeste à la propriété. Mais c’est la finalité de traitement qui y est associée, et surtout la nature des données (personnelles ou non) qui permet de juger de sa licéité. Par exemple, récupérer des adresses ou numéros de téléphone, afin de s’en servir pour des finalités auxquelles leurs propriétaires n’ont pas consenti est préjudiciable. La société de restauration Nestor, qui utilisait des données LinkedIn pour sa prospection commerciale a ainsi écopé en janvier 2021 d’une amende de 20 000€ par la CNIL. Il s’agit donc de bien cadrer quels types de données sont scrapées, en quelle quantité, et ce qu’il va en être fait, pour estimer au mieux les éventuels risques juridiques associés. Néanmoins, dans la mesure où aucune rupture de serveurs n’est causée par des requêtes de scraping trop nombreuses, la pratique est assez courante, connue et tacitement acceptée entre acteurs concurrents qui y ont recours.

Les limitations techniques du scraping

Pour se prémunir face à des robots qui alourdissent la charge à supporter par leurs serveurs, et pour protéger leurs données de la concurrence, les sociétés les plus avancées (Leboncoin, Foot Locker, La Redoute, Rakuten…) s’équipent de solutions de protection, comme DataDome. Ces outils fonctionnent comme des filtres qui bloquent les navigations douteuses, ou affichent des Captcha en cas d’incertitude sur la nature de la session. Des solutions techniques existent, rendant les robots scrapers moins suspects, en faisant varier leurs adresses IPs, ou leurs users agents.

Le scraping de la donnée, comment faire ?

Mettre en place une stratégie opérationnelle basée sur la donnée de la concurrence nécessite donc un cadrage très précis. Il s’agit de bien définir en amont d’un projet de scraping le périmètre le plus pertinent sur lequel investir du temps de travail, avant de se lancer dans l’analyse de grands volumes de données.

- Quel objectif business derrière le besoin ?

Est-ce que je souhaite utiliser la donnée de mes concurrents pour challenger la profondeur de mon catalogue ? Pour affiner mon positionnement tarifaire ?

- Quelle granularité de la donnée pour mon besoin ?

Définir l’objectif business en jeu permet de sélectionner les champs pertinents qui seront à récolter lors de l’aspiration de la donnée.

- Quel périmètre concurrentiel est concerné par l’étude ?

Une des tentations premières des entreprises est de choisir pour ce type d’études une liste riche et exhaustive de leur panorama concurrentiel. Ce choix a souvent pour conséquence d’obtenir des volumes de données massifs et difficilement analysables. Une bonne pratique consiste à lister les principaux acteurs d’intérêt et de fonctionner par itération avec une approche ROIste : intérêt du concurrent pour moi vs complexité à récupérer sa donnée.

- Quelle restitution pour l’analyse ?

Une fois extraites, il s’agit de donner du sens aux données récupérées, et l’analyse des informations scrapées constitue également un défi pour les entreprises. Aller au-delà de la simple compilation des données concurrentes, nécessite un travail d’uniformisation des données récupérées, pour pouvoir comparer des offres qui ne sont pas toujours homogènes, afin d’en retirer des insights à activer. Une fois les données uniformisées et en fonction du besoin business, il s’agit de décider si une analyse one-shot suffit ou si le besoin nécessite par exemple la mise en place d’un dashboard opérationnel.

Une bonne pratique pour garantir le succès de ces sujets consiste à intercaler entre le cadrage et l’analyse sur de gros volumes de données une première analyse manuelle permettant d’affiner le cadrage tout en sortant rapidement de premiers insights (manquements dans le catalogue de produits, difficultés dans le matching des catégories produits …)

Pour plus d’informations, vous pouvez nous contacter directement.

Auteurs :

- Marie Jansen, Consultante, Converteo

- Fabien Traventhal, Consultant senior IT, Converteo Technology

- Thomas Dubois, Manager, Converteo

- Pierre-Eric Beneteau, Practice Leader, Converteo