Compte-rendu : Google cloud summit

Converteo était présent le mardi 5 Juin 2018 la deuxième édition de Google Cloud Summit Paris. En tant que partenaire et reseller Google, les experts data et data scientists de l’équipe Converteo accompagnent au quotidien de nombreux clients dans l’exploitation avancée de l’écosystème GCP et plus précisément dans le déploiement de cas d’usage à forte valeur métier et marketing (optimisation des investissements média, personnalisation des parcours clients, segmentation comportementale, prédiction des ventes, prédiction d’anti-churn, tableaux de bord 360, outils décisionnels, …).

Au fil de nombreuses conférences ayant comme intervenants des acteurs de poids du marché français et mondial, comme Total, Airbus, Dailymotion, Bnp Paribas, Natixis, La Redoute, Google a réexposé sa stratégie d’implantation et de croissance sur un marché français et mondial du cloud qui reste encore timide, avec seulement 5% de taux de pénétration.

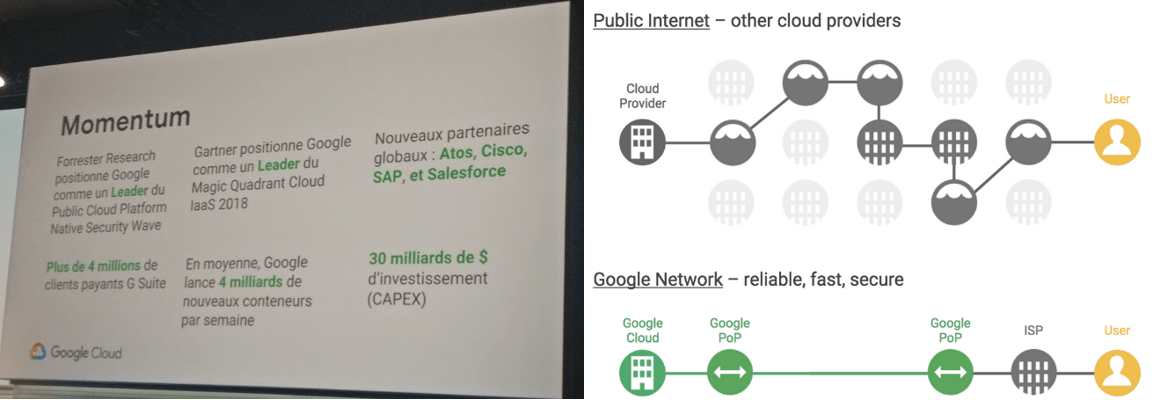

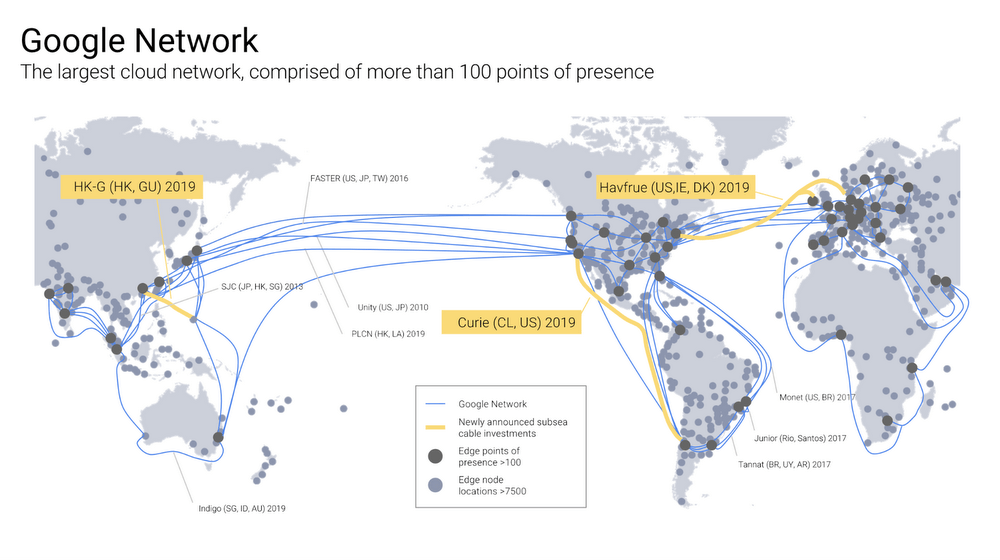

- Fiabilité et performance : un investissement annoncé de 30 milliards de dollars pour renforcer son assise en termes d’infrastructure, avec le développement de nouveaux data centers et réseaux de câbles sous-marins. Ceci permet à Google d’assurer sa position de leader sur le marché du cloud en termes performance.

- Sécurité : le ton est donné par le rappel du mot d’ordre de Google Cloud concernant la sécurité : « Zero Trust », un modèle de sécurité qui a donné naissance à l’offre Google BeyondCorp. La démo de l’API DLP renforce l’importance que Google porte à la sécurité des données, ceci dans un contexte européen bousculé par la RGPD.

- Support : trois niveaux de support proposés par Google Cloud : Silver, Gold et Platinum pour accompagner au quotidien les équipes en charge de GCP.

- Gestion des coûts : Google Cloud Platform repose sur un modèle économique pay-as-you-go (facturation à l’utilisation), les utilisateurs payant seulement en fonction des ressources qu’ils consomment.

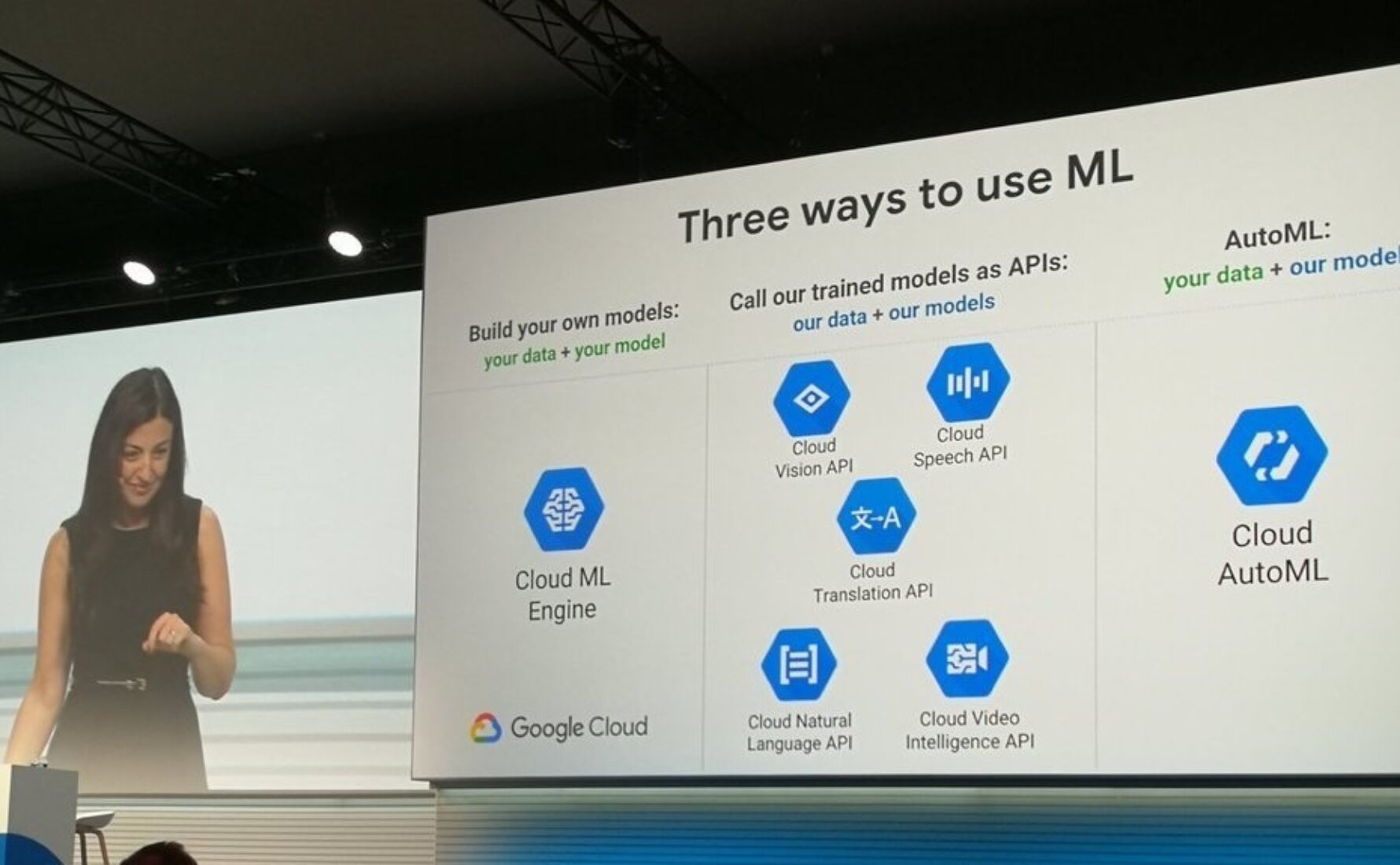

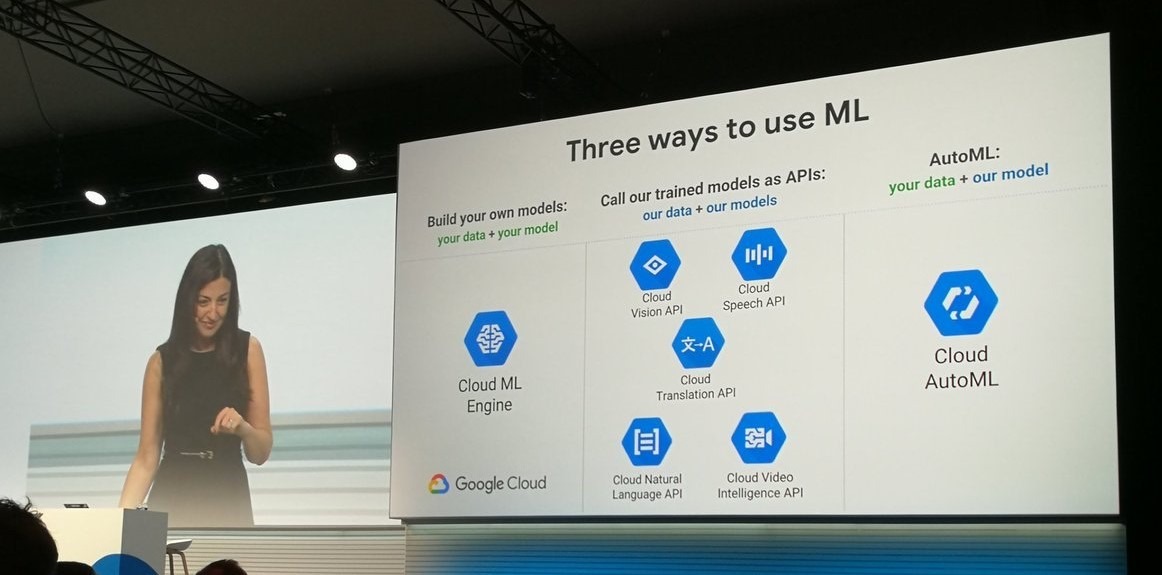

- Utiliser ses propres datasets et la conception (notamment avec TensorFlow) de ses propres modelés prédictifs, entrainés ensuite et déployés via Cloud ML Engine. Mais cette approche DIY exige de disposer des compétences extrêmement poussées demeurant encore rares sur le marché.

- Utiliser les 5 solutions API mises à disposition par GCP : Vision API, Speech API, Translation API, Natural Language API et Video Intelligence API. Cette approche a le mérite de proposer des modèles prêts à l’emploi et assez simples d’utilisation.

On attend avec impatience le Google Cloud Summit Paris 2019 pour, espérons-le, un nouveau changement de paradigme, peut-être cette fois, l’accès aux quantum computers.

Auteur : Danielle Sarant, Consultante Senior